Cachekoherens: Hur cache-synkronisering bevarar minneskonsistens

Cachekoherens: Lär dig hur cache-synkronisering säkerställer minneskonsistens i flerkärniga system, förhindrar inkonsistens och optimerar prestanda.

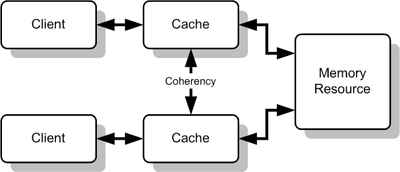

En cache kan användas för att förbättra prestandan vid åtkomst till en viss resurs. När det finns flera sådana cacher för samma resurs kan det leda till problem om de inte hålls i synk. Cachekoherens eller Cache coherency avser de mekanismer som ser till att alla cacheminnen för en resurs innehåller konsekventa och meningsfulla data (så kallad dataintegritet). Cachekoherens är ett specialfall av minneskoherens och är särskilt viktigt i system där flera klienter eller processorer kan läsa och skriva samma minnesområden samtidigt.

Problem uppstår när kopior av samma minnesblock finns i flera cacheminnen. Om en klient skriver till sin cache utan att övriga cachar uppdateras eller informeras, kan andra klienter få gamla eller felaktiga värden. Ett vanligt exempel är CPU:ernas cache i ett flerprocessorsystem: om en processor har en kopia av ett minnesblock från en tidigare läsning och en annan processor ändrar det minnesblocket, kan den första processorn stå kvar med en ogiltig eller föråldrad cache utan att veta om det. Cachekoherensmekanismer syftar till att hantera sådana konflikter och säkerställa att alla cacher och huvudminnet håller sig i ett konsistent tillstånd.

Varför cachekoherens är viktig

- Korrekthet: Utan koherens kan program få olika, oförutsägbara resultat eftersom läsningar kan returnera gamla värden.

- Prestanda: Rätt designade koherensprotokoll minskar onödiga minnesåtkomstlatens genom att tillåta lokala cachar att användas säkert.

- Skalbarhet: I stora flerkärniga eller distribuerade system blir hantering av delat data avgörande för att undvika fel och flaskhalsar.

Vanliga orsaker till inkonsekvens

- Parallella skrivningar: Två eller flera klienter skriver till samma minnesadress utan synkronisering.

- Föråldrade kopior: En cache innehåller en tidigare version efter att en annan cache uppdaterat värdet.

- Fördröjda uppdateringar mellan cache och huvudminne.

Strategier för att upprätthålla koherens

Det finns två huvudstrategier för att hålla cachar koherenta:

- Write-invalidate: När någon skriver till ett block invalidiseras kopior i andra cacher. Skrivarens cache får ensam skrivbehörighet. Detta minskar antalet skrivmeddelanden men kan leda till fler cache-missar för andra läsare.

- Write-update (write-broadcast): När ett block skrivs sänds den nya datan till alla andra cacher så att de uppdateras. Detta bevarar läsarnas kopior men ökar nätverkstrafiken eller bussbelastningen.

Koherensprotokoll — exempel

Maskinvaruimplementerade protokoll används ofta i CPU-cacher. Vanliga protokoll:

- MSI: Tre tillstånd — Modified, Shared, Invalid. Enklare men mindre effektivt i vissa scenarier.

- MESI: Fyra tillstånd — Modified, Exclusive, Shared, Invalid. Tillåter att en cache innehar en exklusiv oförändrad kopia (Exclusive) vilket minskar busskommunikation vid läsning följt av skrivning.

- MOESI och andra varianter: Inkluderar även ett Owned-state för att optimera skrivning utan omedelbar skrivning tillbaka till huvudminnet.

Snooping vs directory-baserade protokoll

- Snooping: Alla cachekontrolllogiker "lyssnar" på en gemensam buss. När en cache skriver eller frågar om ett block kan andra cacher agera direkt. Lämpligt för mindre system med snabb gemensam buss.

- Directory-baserat: En central katalog (directory) håller reda på vilka cacher som har kopior av varje block. Skalbart till fler noder och används ofta i stora distribuerade minnessystem.

Cachekoherens vs minneskonsistens

Det är viktigt att skilja mellan begreppen:

- Cachekoherens: Handlar om att alla kopior av samma minnesplats i olika cacher överensstämmer — att uppdateringar når eller invalidiserar andra kopior.

- Minneskonsistens (memory consistency): Handlar om i vilken ordning en processors minnesoperationer blir synliga för andra processorer (exempelvis sekvensen av läsningar och skrivningar). Korrekt koherens är en förutsättning, men konsistensmodellen beskriver programmets semantik över tid.

Utmaningar och prestandatrade-offs

- Kommunikationskostnad: Särskilt i stora system kan koherensmeddelanden bli en flaskhals.

- False sharing: Två trådar skriver till olika data som råkar ligga i samma cachelinje — leder till onödiga invalidiseringar och prestandaförluster.

- Skalbarhet: Snooping fungerar bra i mindre system, men directory-baserade lösningar krävs för att skala.

Praktiska exempel och åtgärder

- På mjukvarunivå: Använd lås, atomiska operationer och minnessynkronisering för att undvika konkurrens om delade data.

- På hårdvarunivå: Välj rätt koherensprotokoll och organisera data för att minimera false sharing (t.ex. genom att padd:a strukturer så att ofta ändrade variabler inte hamnar i samma cachelinje).

- Verktyg: Profileringsverktyg och simuleringar kan identifiera koherensrelaterade flaskhalsar.

Sammanfattning

Cachekoherens är en grundläggande funktion i flerkärniga och distribuerade system för att säkerställa att flera kopior av samma data inte blir inkonsekventa. Genom koherensprotokoll, lämpliga skrivpolicyer och genomtänkt programdesign kan man både upprätthålla korrekthet och minimera prestandapåverkan. För stora system används ofta directory-baserade protokoll, medan snooping-lösningar är vanliga i mindre, bussbaserade arkitekturer.

Flera cachemiljöer för delad resurs

Definition

Samstämmighet definierar hur läs- och skrivningar till samma minnesplats beter sig. Caches är sammanhängande om alla följande villkor är uppfyllda:

- När en processor P läser en plats X, efter att ha skrivit till den platsen, måste P få det värde som den skrev, om ingen annan processor skrev ett annat värde till den platsen. Detta gäller även för monoprocessorsystem, vilket innebär att minnet kan behålla ett skrivet värde.

- Antag att det finns två processorer, P1 och P2, och att P1 skrev ett värde X1 och att P2 därefter skrev ett värde X2. Om P 1läser värdet måste den få det värde som P2 skrev, X2, och inte det värde som P skrev, X1, om det inte finns några andra skrivningar mellan de två. Detta innebär att synen på minnet är sammanhängande. Om processorer kan läsa samma gamla värde efter det att P2 har skrivit det skulle minnet inte vara sammanhängande.

- Det kan bara skrivas en gång i taget till en viss plats i minnet. Om det finns flera skrivningar måste de ske efter varandra. Med andra ord, om plats X fick två olika värden A och B i denna ordning av två processorer, kan processorerna aldrig läsa plats X som B och sedan läsa den som A. Plats X måste ses med värdena A och B i denna ordning.

Dessa villkor definieras under förutsättning att läs- och skrivoperationer utförs omedelbart. Detta sker dock inte i datorhårdvara på grund av minnesfördröjning och andra aspekter av arkitekturen. En skrivning från processor X kanske inte ses av en läsning från processor Y om läsningen sker inom en mycket kort tid efter det att skrivningen har gjorts. Minneskonsistensmodellen definierar när ett skrivet värde måste kunna ses av en följande läsinstruktion som görs av andra processorer.

Mekanismer för sammanhållning av cacheminnet

- Katalogbaserade sammanhållningsmekanismer upprätthåller en central katalog över cachade block.

- Snooping är den process där varje cache övervakar adressrader för åtkomst till minnesplatser som finns i dess cache. När en skrivoperation observeras till en plats som en cache har en kopia av, ogiltigförklarar cachekontrollanten sin egen kopia av den snokade minnesplatsen.

- Snarfing innebär att en cache-kontrollant övervakar både adress och data i ett försök att uppdatera sin egen kopia av en minnesplats när en annan master ändrar en plats i huvudminnet.

Distribuerade delade minnessystem efterliknar dessa mekanismer så att de kan upprätthålla konsistens mellan minnesblock i löst kopplade system.

De två vanligaste typerna av sammanhållning som vanligtvis studeras är snokning och katalogbaserad. Var och en har sina egna fördelar och nackdelar. Snooping-protokoll tenderar att vara snabbare, om tillräcklig bandbredd finns tillgänglig, eftersom alla transaktioner är en begäran/svar som ses av alla processorer. Nackdelen är att snooping inte är skalbart. Varje begäran måste sändas till alla noder i ett system. När systemet blir större måste storleken på den (logiska eller fysiska) bussen och den bandbredd som den tillhandahåller öka. Kataloger tenderar å andra sidan att ha längre väntetider (med en begäran/vidarebefordran/svar med tre hopp) men använder mycket mindre bandbredd eftersom meddelanden är punkt till punkt och inte sänds ut. Av denna anledning använder många av de större systemen (>64 processorer) denna typ av cachekoherens.

Frågor och svar

F: Vad är cachekohärens?

S: Cachekoherens innebär att man ser till att alla cacheminnen av en resurs har samma data och att data i cacheminnena är konsekventa (dataintegritet).

F: Vad är syftet med cachekoherens?

S: Syftet med cachekoherens är att hantera konflikter mellan flera cacher för en gemensam minnesresurs och upprätthålla konsistens mellan cache och minne.

Fråga: Vilka konsekvenser kan det få om cachekoherens saknas?

S: Utan cachekoherens kan det hända att data i cacheminnet inte längre är meningsfulla, eller att ett cacheminne inte längre har samma data som de andra, vilket kan leda till inkonsekvenser och fel.

F: Vad är ett vanligt fall där problem med cachekohärens uppstår?

S: Ett vanligt fall där problem med cachekoherens uppstår är cacheminnet för CPU:er i ett flerprocessorsystem.

F: Hur fungerar cachekoherens?

S: Cachekoherens fungerar genom att se till att alla cacheminnen för en resurs har samma data och att data i cacheminnena är konsekventa med hjälp av olika metoder.

F: Vad menas med minneskoordinering?

S: Med minneskohärens avses att data är konsekventa i en delad minnesresurs.

F: Hur kan cachekoherens förbättra prestandan?

S: Cachekoherens kan förbättra prestandan genom att möjliggöra snabbare och effektivare åtkomst till en viss resurs.

Sök